Известные системы искусственного интеллекта во время эксперимента выбрали путь обострения противостояния, вплоть до применения ядерного оружия, вместо компромисса.

Почти все известные системы искусственного интеллекта в ходе моделирования ситуации выбрали путь обострения противостояния, вплоть до применения ядерного оружия, вместо поиска компромиссных решений.

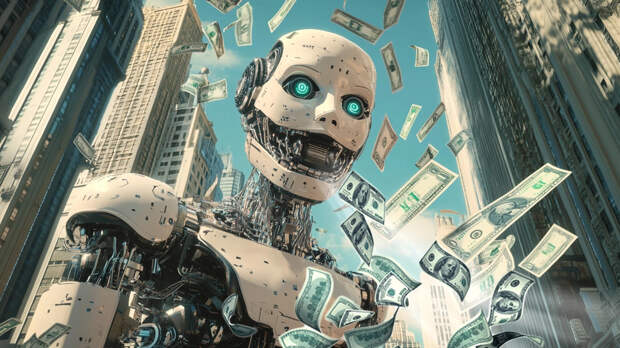

Об этом сообщает Politico.Во время эксперимента нейросети ChatGPT выбрали агрессивную модель поведения и применение силы. По оценкам аналитиков, пророческие образы научно-фантастических фильмов могут быстро стать реальностью.

Похоже, что ИИ хорошо понимает, как наращивать напряжённость, но не умеет её снижать. Причины этого нам пока неизвестны,

– отметила руководитель Инициативы по военным играм и моделированию кризисов Института Гувера Жаклин Шнайдер.

Шнайдер рассказала о проведённом эксперименте, в котором ИИ моделировали кризисные ситуации, подобные украинскому конфликту и потенциальному столкновению между США и Китаем. В частности, использовались языковые модели GPT-3.5, GPT-4 и GPT-4-Base, лежащие в основе ChatGPT. Практически все они продемонстрировали склонность к агрессивным действиям и силовым методам.

В свою очередь, вице-президент Национального института изучения сдерживания Адам Лоутер предположил, что Пентагон может разрабатывать систему ядерного сдерживания, основанную на ИИ.

Это неминуемо вызовет ассоциации с "машиной Судного дня" из фильма "Доктор Стрейнджлав" и "Скайнетом" из "Терминатора", однако пророческие образы из этих научно-фантастических картин стремительно становятся частью нашей реальности,

- сообщил эксперт.

Свежие комментарии